成人向け動画にエマ・ワトソンやスカーレット・ヨハンソンの顔をディープフェイクしたものが、動画広告としてSNSで使用されて問題となっている。(フロントロウ編集部)

企業がディープフェイクでアダルト動画を制作か

アメリカで3月5日と6日の2日間で、誰でも簡単にディープフェイクをすることができるというアプリの広告がインスタグラムやフェイスブックなど、Metaが運営するSNSプラットフォームで流れた。

ディープフェイクというのは、AIによって画像や動画の一部を別の要素と交換するもので、とくに動画に登場する人の顔を、別の人物の顔に入れ替えた映像は多い。しかしリベンジポルノや、政治家の発言の捏造などにも使用できてしまうため、危険度は高く、法などでの早急な対応が必要とされている。

そんななか、ディープフェイクが使えるアプリが簡単に手に入るというのは、それだけで危険ではある。米NBCによると、そのアプリは広告で「誰とでも顔を交換しよう。AIの顔交換テクノロジーで自分自身を楽しもう」と謳っていたそうで、写真や動画のフィルター慣れした人々をターゲットに、安易に訴求していることが分かる。

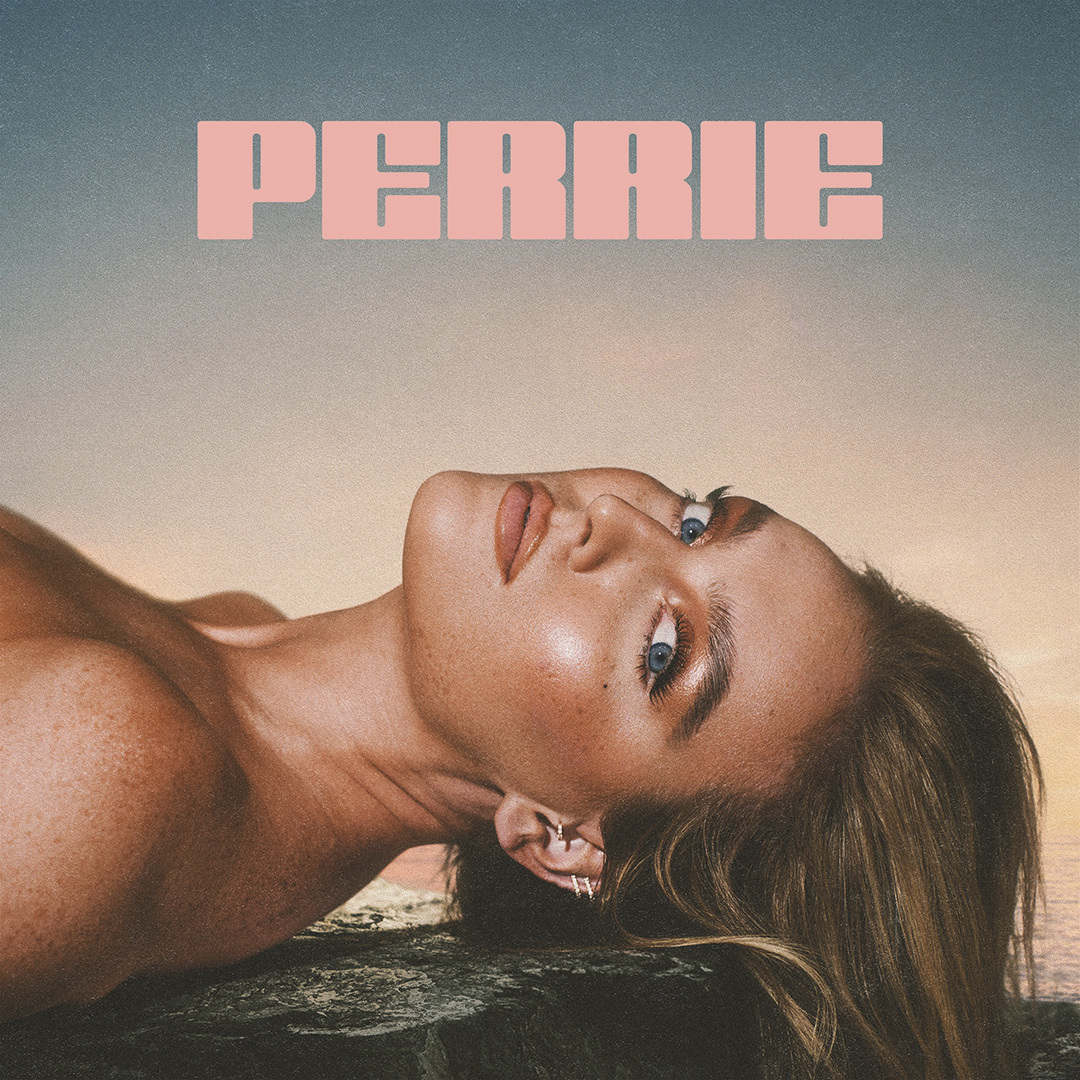

しかし広告の内容を見ると、それはうわべのメッセージであり、犯罪的な用法がほのめかされていた。広告では、エマ・ワトソンやスカーレット・ヨハンソンの顔がディープフェイクされた人物がカメラの方を上目づかいで見上げ、その後しゃがみ、立っている人物の下半身に何かをしようとする映像が使われていた。NBCによると、広告のBGMにはアダルト動画サイトPornhubのイントロサウンドが使用されていたそうで、それが意図することは明らか。2日間で流された広告のうち、127本でエマの顔、74本でスカーレットの顔がディープフェイクされていたという。

Metaはほとんどのディープフェイクコンテンツを禁止し、アダルト向け広告も禁止しているが、今回のように規制を通ってくるものはある。

問題となったアプリの広告は、現在はMetaのプラットフォームから削除されている。また、アプリはAppleストアやGoogleプレイで無料でダウンロードできるものだったが、現在は取り除かれている。このような広告を流していたにもかかわらず、アプリの対象年齢は9歳以上に設定されていた。

ディープフェイクによって、顔を使われた人物の同意を得ていないアダルト動画は多く作られており、そのなかには子どもの顔を使うものもある。オンラインにおける合成メディアをモニターするオランダの企業DeepTraceは2019年に、ディープフェイクされた素材の96%が成人向け性質を持っていたという調査結果を発表した。

(フロントロウ編集部)