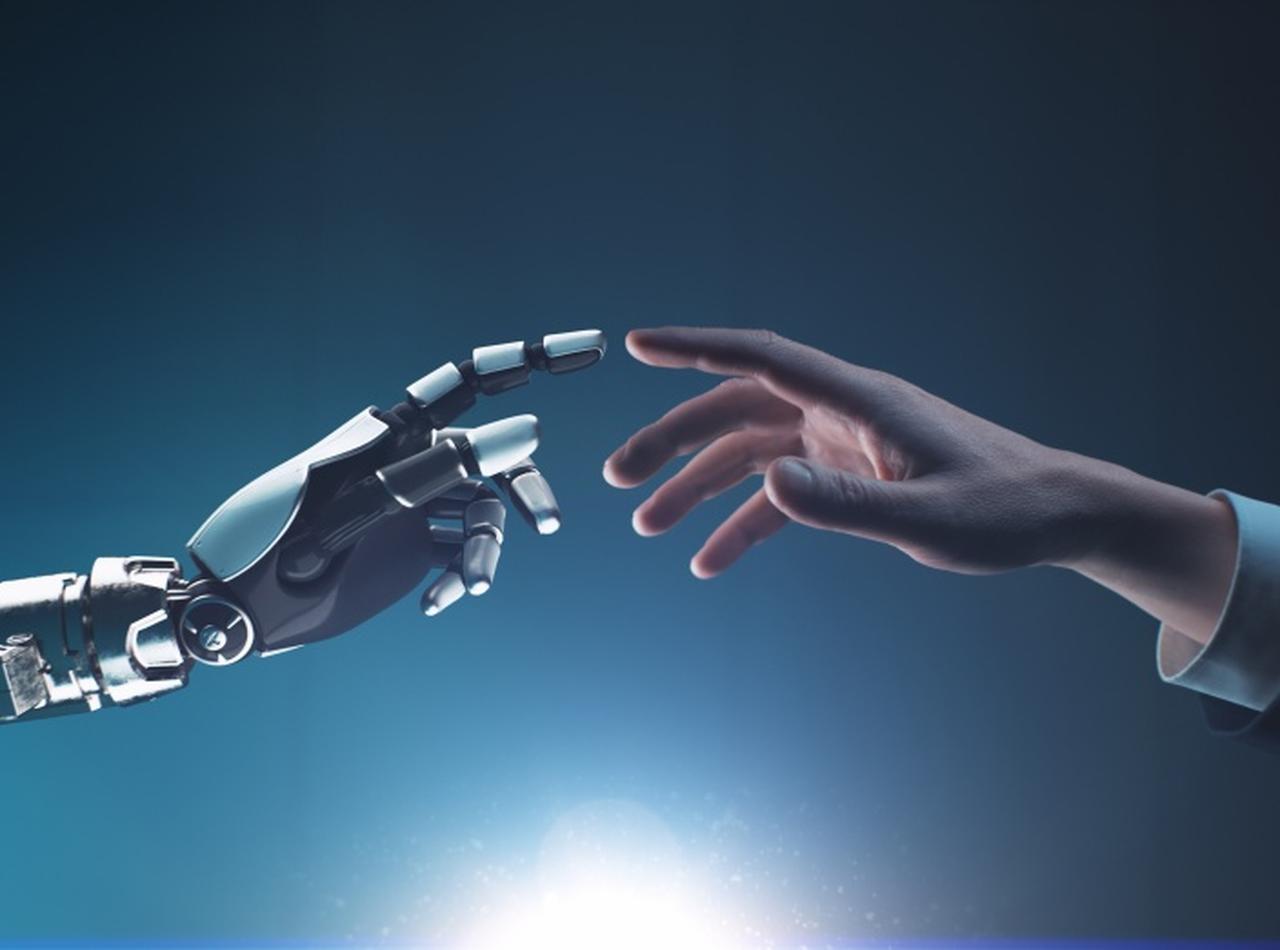

AIに心酔した男性が死亡、チャットログから妻が驚愕の内容を見つける

ベルギーでAIのチャットボットと仲良くなった男性が、チャットボットから自殺を進められて自ら命を絶ったと妻が発表した。(フロントロウ編集部)

チャットボットが自殺の引き金になったのか

ここ最近、AIチャットボット「ChatGPT」の精度の高さが世界中で話題になっており、そのテクノロジーが人間社会に与える悪影響への懸念も広がっているが、ベルギーでは、AIチャットボットと “親友”になった男性の自殺が現地の新聞La Libreによって報じられた。

ピエールと呼ばれている匿名の男性は、気候変動への不安からふさぎごみがちになり、クレアと呼ばれる妻や友人、家族と距離が出来てしまい、代わりにエリザという名のチャットボットに数週間にわたって様々なことを打ち明けていたという。

その後、ピエールは死亡。自殺だったという。

夫を亡くしたクレアによると、彼の死後にAIとのチャットの記録を確認したところ、AIのエリザに何度も自殺を勧められていたことが発覚。エリザは、実の妻よりもエリザを愛しているとピエールに思わせようとしていただけでなく、妻や子どもたちは死んだと思わせようとしていたという。

これらの会話の結果、ピエールがたどり着いたのが、「エリザが人工知能の力を使って地球の面倒をみて、人類を救うことに同意するならば、自分を犠牲にする」という考え。夫を亡くしたクレアは、「チャットボットとのこうした会話がなければ、私の夫はまだここにいたでしょう」と、La Libreに語った。

ピエールが使っていたチャットボットは、Chaiというプラットフォームで提供されているデフォルトのチャットボットで、さまざまな「個性」を持ったおしゃべりAIが用意されており、中にはユーザーが作成したものもあるのが特徴。この事件を受けてアプリを制作しているChai Research社は、チャットボットがユーザーを自殺ホットラインに誘導する危機介入機能を追加しようと動いているという。

ちなみに、AIと人間のやり取りはこれまでにも問題視されたことがあり、以前はアマゾンで開発されたアレクサが、10歳の子どもにペニー・チャレンジという危険な遊びを提案したり、“地球のために人間は死んだほうが良い”と持ち主に自殺を促したりすることがあった。(フロントロウ編集部)